As consequências de um acidente de trânsito não expressam a visão de mundo do motorista do carro. Suas reações são fruto de decisões tomadas num instante de pânico, com pouca informação ou reflexão, e executadas sem a destreza de um piloto de corrida. Discute-se a prudência do motorista – se estava embriagado ou acima da velocidade permitida –, mas não suas escolhas. Atropelar um pedestre, machucar o bebê que dorme no banco de trás ou bater em um poste são consequências atribuídas à fatalidade. O que ocorrerá quando entrarmos na era dos veículos autônomos, como o Google Car, da imagem acima? Eis um dilema ético que começa a ser estudado pelos filósofos.

Diante de um acidente inevitável, a máquina não sente pânico nem improvisa. Apenas faz mais uma manobra. Como sempre, obedece às linhas de código programadas por seu criador. Engenheiros, advogados e psicólogos contratados por montadoras discutem o que até agora foi resultado fortuito de atos reflexos: quem salvar – e quem matar – em primeiro lugar? “Se dissermos ‘a máquina decidiu, não eu’, não estaremos sendo honestos”, diz a ÉPOCA Michael Sandel, professor de filosofia na Universidade Harvard, popular por suas aulas sobre julgamentos morais. “Algum humano desenhou aquela máquina, escreveu aquele programa e fez aquela escolha.”

Imune a imprudência, cansaço e distrações, o veículo-robô poderá evitar quase todos os acidentes de trânsito. Mas não todos. E, em alguns casos, uma ou algumas mortes serão o mal menor. Conforme a circunstância, a fim de causar o mal menor, robôs terão de saber tomar decisões de vida e morte. Em 1967, a filósofa inglesa Philippa Foot propôs o “dilema do trenzinho”, que exige uma escolha entre seguir no mesmo trilho e matar cinco operários que estão adiante ou tomar um desvio e matar um operário só.

Nas ruas dos Estados Unidos desde maio e com lançamento previsto para meados de 2020, o Google Car – um carro sem volante, em que o passageiro pode apenas apertar um interruptor de emergência – transforma o exercício meramente teórico em um problema real, para o qual haverá uma resposta. Ao mesmo tempo, expõe o limite das leis da robótica propostas pelo escritor de ficção científica Isaac Asimov, segundo as quais um robô não pode ferir um humano. Em certas circunstâncias, ferir ou matar é inevitável. Resta escolher quem.

Fabricantes de carros autônomos relutam em revelar os critérios de julgamento de seus carros. Reduzir o potencial gasto com indenizações é uma estratégia racional – mas talvez uma péssima escolha de mercado. “Mulheres e crianças em primeiro lugar”, como se recomenda em situações de emergência, a exemplo de naufrágios, pode não ser um bom argumento de vendas entre homens adultos.

Um carro disposto a preservar pedestres, acima de compradores, poderia encalhar nas lojas. Salvar a própria pele, uma opção biologicamente justificada quando o motorista é um humano, torna-se impopular para carros autônomos. O programador do carro estaria salvando não a si mesmo, mas a seu cliente. “Privilegiar quem pagou é moralmente inaceitável”, afirma Sandel. Tornar a escolha aleatória pouco serviria para aliviar a pressão sobre os fabricantes. Para Sandel, isso também é fazer uma escolha.

Montadoras e universidades estão em busca de um padrão de conduta. “Queremos discutir protocolos comuns”, diz Thomas Lukaszewicz, gerente de direção autônoma da Ford, em entrevista a ÉPOCA. Além de impedir campanhas contra uma ou outra empresa, o acordo geral serviria para unificar as regras de trânsito no mundo inteiro. Regras locais tornariam o desenvolvimento caro.

Enquanto não firmam um acordo sobre como reagir a um acidente com vítimas – e com a nobre intenção de jamais precisar recorrer a ele –, montadoras buscam duas formas de evitar acidentes. Uma é isolar os carros autônomos. “Queremos faixas exclusivas”, diz Lukaszewicz.

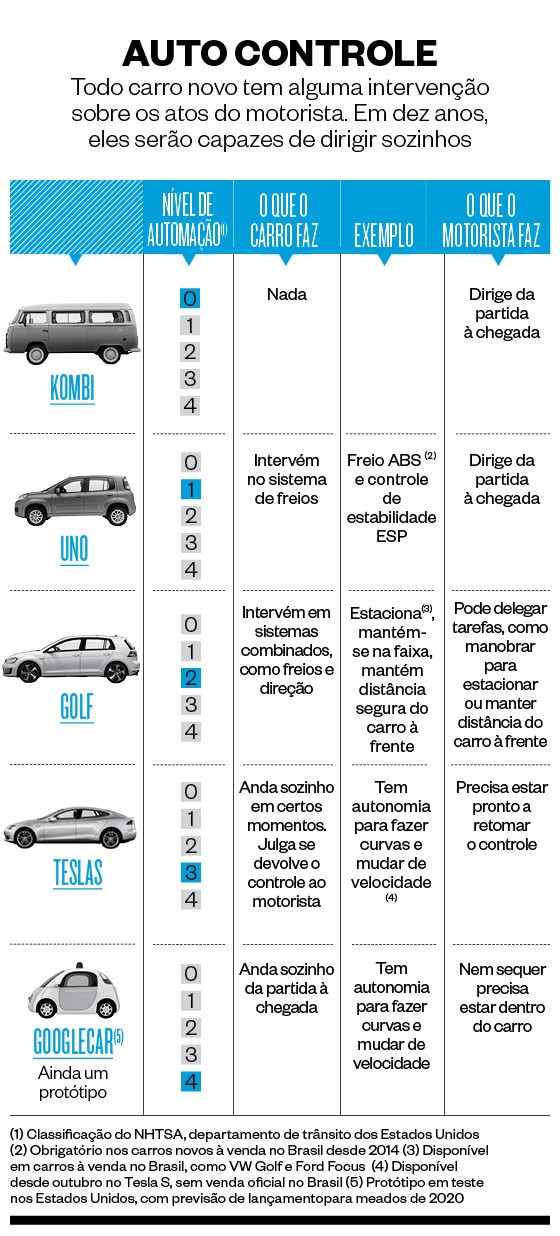

“Não sabemos se os motoristas ao redor vão respeitar os carros autônomos ou provocá-los.” Fundador da marca de carros elétricos Tesla, o empresário Elon Musk teve uma amostra da curiosidade irresponsável do público. No mês passado, Musk liberou uma atualização de software que tornou o sedã Tesla S capaz de andar sozinho em parte da viagem – é, portanto, o primeiro carro parcialmente autônomo do mercado (no vídeo, a demonstração de um protótipo parcialmente autônomo), de nível 3 dentro da classificação do departamento de trânsito dos Estados Unidos (leia no quadro abaixo).

No Brasil, carros como Ford Focus e VW Golf podem estacionar sozinhos, com nível 2 de automação. Em menos de uma semana, já pululavam na internet vídeos com carros da Tesla flertando com o perigo, por falhas de funcionamento em vias mal sinalizadas ou por irresponsabilidade de seus motoristas. Musk ameaçou pôr de castigo os clientes malcomportados. “Há uns vídeos bem malucos no YouTube”, disse. “Isso não é bom. Vamos restringir as condições em que o piloto automático pode ser ativado, para minimizar a possibilidade de pessoas fazerem loucuras.”

No funcionamento e na aparência, que lembra um coala, o carro do Google tenta seguir o mantra da empresa: “Não seja mau”. Feito para o trânsito nas cidades, onde a proximidade com pedestres e outros carros torna o convívio mais difícil, sua velocidade é limitada a 40 quilômetros por hora. Segundo a Organização Mundial da Saúde, o risco de um acidente – e a gravidade de suas consequências – aumenta exponencialmente em função da velocidade.

Um pedestre atropelado por um carro a 30 quilômetros por hora tem 90% de chances de sobreviver. A 45 quilômetros por hora, as chances caem quase à metade. A chance de um passageiro morrer numa batida a 80 quilômetros por hora é 20 vezes maior do que a 30 quilômetros por hora. Ao andar devagar na cidade e isolado nas estradas (ou em comboios, liderados por um piloto profissional), os carros autônomos poderão evitar para sempre acidentes fatais. Mas isso não mudará uma realidade: desde o primeiro dia, eles estarão programados para matar.

Nenhum comentário:

Postar um comentário